Oft unterschätzt und doch von entscheidender Bedeutung: Die richtige Konfiguration von Apache Kafka Partitions spielt eine zentrale Rolle für die Effizienz und Stabilität von event-orientierten Architekturen. Viele Softwareentwickelnde und Unternehmen neigen dazu, die Wichtigkeit dieser Konfiguration zu vernachlässigen, was zu suboptimalen Systemleistungen und unerwarteten Herausforderungen führen kann.

Kafka

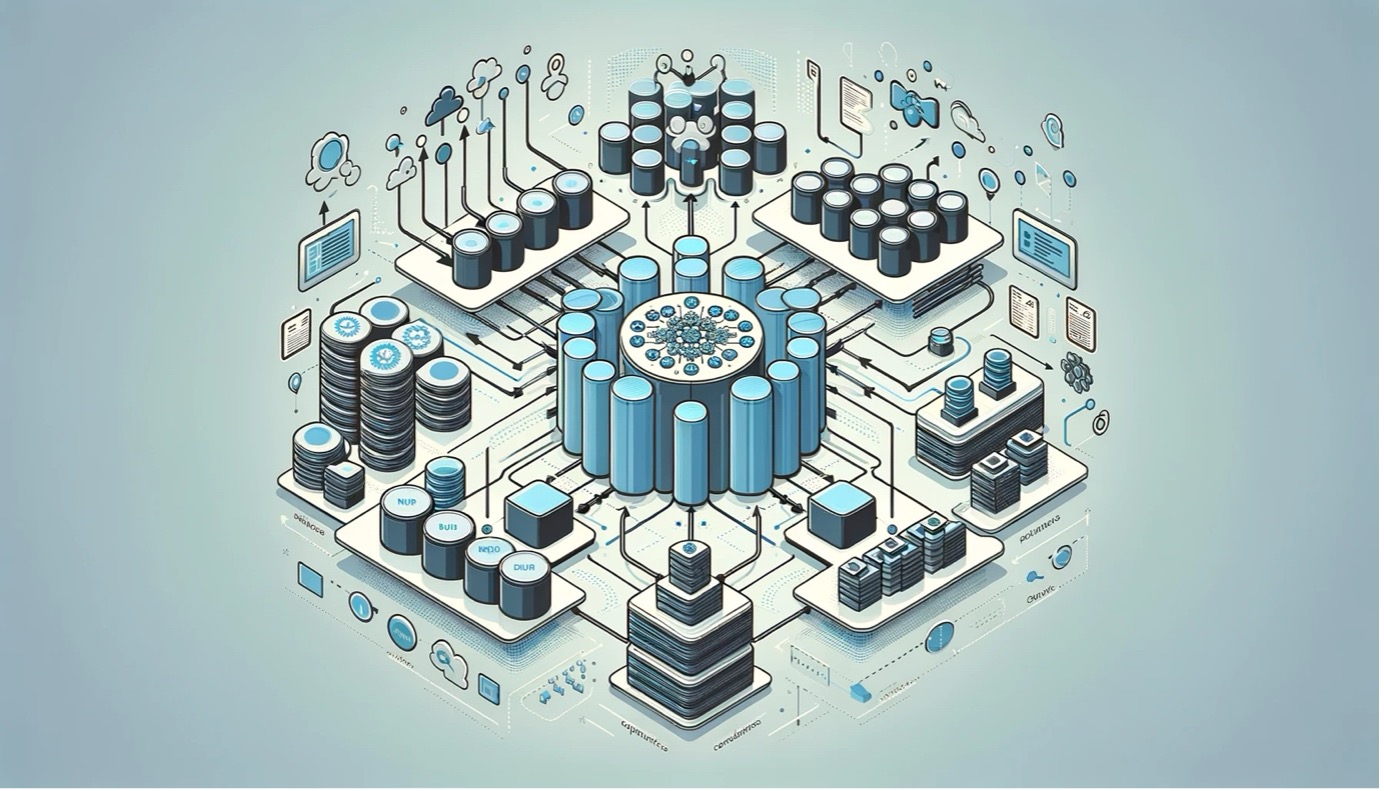

Apache Kafka ist eine verteilte Streaming-Plattform, welche häufig für die Verarbeitung grosser Datenmengen in Echtzeit verwendet wird. Ursprünglich von LinkedIn entwickelt wurde es später als Open-Source-Projekt unter der Apache Software Foundation veröffentlicht. Kafka ermöglicht es Datenströme von diversen Systemen unternehmensweit effizient zu verarbeiten, zu analysieren und Daten diversen Konsumenten-Systemen zu Verfügung zu stellen. Der Kreativität von möglichen Anwendungsfällen sind im Rahmen der Digitalisierung dabei kaum Grenzen gesetzt.

Partitions

Umgangssprachlich wird bei Apache Kafka oft davon gesprochen, dass Daten in ein Topic geschrieben, bzw. aus einem Topic gelesen werden. Effektiv werden die Daten dabei aber in Partitionen geschrieben und von konsumierenden Systemen aus diesen wieder gelesen. Ein Kafka Topic bildet dabei lediglich einen logischen Verbund über die Anzahl der Partitions, welche für ein Topic definiert sind.

Um die Bedeutung von Partitions zu verstehen, muss die Thematik dabei aus drei unterscheidlichen Perspektiven betrachtet werden: als Einheit der Parallelität (Unit of Parallelism), als Einheit der Speicherung (Unit of Storage) und Einheit der Haltbarkeit (Unit of Durability).

Unit of Parallelism

Partitions in Kafka können primär als Einheiten der Parallelität verstanden werden. Dies bedeutet, dass die Datenverarbeitung innerhalb eines Kafka-Clusters über verschiedene Partitions hinweg parallelisiert wird. Jede Partition kann von einem separaten Consumer innerhalb einer Consumer-Gruppe unabhängig gelesen werden, was die Verarbeitungsgeschwindigkeit erheblich erhöht. Die Parallelisierung ermöglicht es Kafka, hohe Durchsatzraten zu erreichen, da mehrere Nachrichten gleichzeitig verarbeitet werden können. Dies ist besonders wichtig in Echtzeitanwendungen, wo schnelle Datenverarbeitung und -replikation unerlässlich ist.

Unit of Storage

Jede Partition wird auf dem Filesystem eines Kafka-Brokers als eine Reihe von Dateien gespeichert. Diese Dateien umfassen sowohl die eigentlichen Daten als auch die Indexdateien, die schnelle Zugriffe ermöglichen. Ein wichtiger Aspekt dabei ist die Verwaltung der File Handler. Jeder geöffnete File Handler repräsentiert eine Partition, und da Betriebssysteme eine maximale Anzahl an gleichzeitig offenen File Handlern haben, wird diese Grenze schnell zu einem kritischen Faktor. Eine hohe Anzahl von Partitions kann dazu führen, dass diese Grenze erreicht oder überschritten wird, was die Systemleistung beeinträchtigen und zu Fehlern führen kann.

Unit of Durability

Die Haltbarkeit (Durability) von Daten in Kafka ist eng mit dem Konzept der Partitions verknüpft. Kafka garantiert die Haltbarkeit von Nachrichten, indem es sie auf die Festplatte schreibt und optional über mehrere Partitions repliziert. Jede Partition kann auf mehreren Brokern repliziert werden, um die Datensicherheit zu erhöhen und das Risiko von Datenverlusten zu minimieren. Diese Replikation sorgt dafür, dass selbst im Falle eines Broker-Ausfalls die Daten verfügbar bleiben, indem sie von anderen Brokern, die Kopien der betreffenden Partitionen halten, abgerufen werden können.

Fazit

Die Konfiguration von Partitions in Apache Kafka ist ein kritischer Aspekt, der die Leistung, Skalierbarkeit und Zuverlässigkeit eines Kafka-Clusters beeinflusst. Sie sind nicht nur ein Mittel zur Speicherung und Verarbeitung von Daten, sondern auch ein zentrales Element, das die Art und Weise, wie Kafka-Daten verarbeitet, speichert und sichert, grundlegend beeinflusst. Eine gut durchdachte Partitionierungsstrategie ist daher unerlässlich, um die volle Leistungsfähigkeit von Apache Kafka auszuschöpfen. Nichtsdestotrotz gibt es keine goldene Regel für die optimale Anzahl der Partitionen, da dies immer vom jeweiligen Anwendungsfall abhängt.

Weiterführende Links:

Dieser Blog-Beitrag wurde mit Unterstützung des Sprachmodells ChatGPT erstellt.