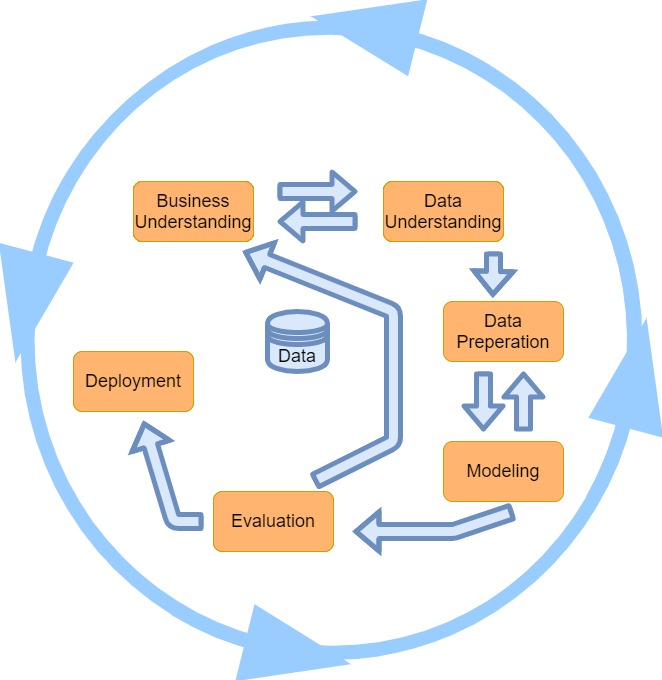

Mit der andauernden Digitalisierung sammeln Unternehmen immer mehr Daten an. Deren Strukturierung und Auswertung sind eine allseits bekannte Herausforderung und benötigen eine klare Vorgehensweise. Das Cross Reference Industry Standard Process for Data Mining (CRISP-DM) von Chapmann führt in sechs Phasen vor, wie Data-Mining (Daten-Bergbau) erfolgreich angewendet wird (Chapman et al. 2000, S. 10 zit. in Baars & Kemper, 2000, S. 153).

Hier lesen Sie, wie man von der Definition der Problemstellung, über die Datenverarbeitung bis zur Informationsbereitstellung schrittweise einen Business-Case im Bereich Datenanalyse angeht.

Business-Understanding

In der ersten Phase müssen die Ziele des Data-Mining-Projekts definiert werden. Eckpunkte können die Kosten und der Zeitrahmen, der erwartete Nutzen, die Geschäftsziele und die involvierten Personen sein.

Data-Understanding

Die potenziell relevanten Daten sollen zusammengetragen werden. Fehlwerte müssen bestimmt, Ausreißer erkannt und die Datenqualität untersucht werden. Deskriptive Statistiken wie Modus, arithmetisches Mittel sowie Streuungsparameter wie Spannweiten und Varianzen helfen, erste Erkenntnisse über die Daten zu gewinnen. Schon in der Phase des Data-Understandings können mit Visualisierungsansätzen wie zum Beispiel Säulen- und Liniendiagrammen erste Grundmuster identifiziert werden. Diese helfen bei der Wahl der Methoden. Neben kommerziellen Data-Mining-Werkzeugen wie Rapid Miner können auch analyseorientierte Skriptsprachen wie R, Python, Matlab oder Julia zum Einsatz kommen.

Data-Preparation

Nun werden in den selektierten Daten vorbereitete Datentransformationen gemacht. Tabellen werden zusammengeführt. In dieser Phase werden Zeilen gruppiert und zusammengefasst (minimale und maximale Umsätze). Attribute werden in Klassen überführt, wie zum Beispiel in die Umsatzklasse. Die relevanten Daten werden gefiltert und selektioniert. Attributwerte müssen umformatiert und eventuell konvertiert werden.

Modelling

Basierend auf den Zielsetzungen des Projekts und der ausgewählten Daten müssen die geeigneten Modellierungstechniken gewählt werden. Diese können einfach statistische Modelle (linearer Regression) bis hin zu komplexeren Methoden, wie zum Beispiel Entscheidungsbäume, neuronale Netze oder Clustering-Algorithmen sein. Die ausgewählten Techniken werden auf die vorbereiteten Daten angewendet. Dabei werden die Daten in ein Format gebracht, das für die jeweilige Modellierungstechnik geeignet ist. Danach werden die Daten typischerweise in Trainings- und Testdatensätze unterteilt. Der Trainingsdatensatz wird verwendet, um das Modell zu trainieren und zu optimieren, während der Testdatensatz dazu dient, die Leistung des Modells zu bewerten und sicherzustellen, dass es gut generalisiert und auf neue, unsichtbare Daten anwendbar ist.

Evaluation

Zuerst wird überprüft, ob die ursprünglichen Projektziele und Geschäftsanforderungen durch die Analyse und das entwickelte Modell erfüllt werden. Es ist wichtig, sicherzustellen, dass die Ergebnisse relevante und nützliche Insights liefern. Die Leistung des entwickelten Modells soll anhand der Metriken bewertet werden. Zur Risiko- und Fehlerminderung gehört eine Analyse, ob das Modell robust genug ist, um es in der Praxis zu verwenden, und ob es potenzielle Fehlerquellen oder Risiken gibt, die minimiert werden sollten. Die Bedeutung der Ergebnisse wird diskutiert, und es wird überprüft, ob sie im Kontext des Geschäftsmodells sinnvoll interpretiert werden können.

Deployment

In dieser Phase geht es darum, die entwickelten Modelle oder Lösungen in die Realität umzusetzen und sicherzustellen, dass sie effektiv im täglichen Geschäft genutzt werden können. Die Modelle oder Algorithmen, die während der Modellierung entwickelt wurden, werden in die Produktionsumgebung überführt (Implementierung). Dies kann die Entwicklung von Softwareanwendungen, Dashboards oder Schnittstellen umfassen, die den Endbenutzern zur Verfügung stehen. Die resultierenden Modelle sollten nahtlos in bestehende Geschäftsprozesse integriert werden. Dies umfasst die Schulung von Benutzern, die Anpassung der Infrastruktur und möglicherweise Änderungen an den Arbeitsabläufen. Nach dem Deployment ist es wichtig, die Leistung des Modells kontinuierlich zu überwachen (Monitoring).

Fazit

Gemäss Baars und Kemper (2020, S. 154) benötigen die Phasen der Problemdefinition, der Datenbeschaffung sowie die Datentransformation bis zu 80 % des Gesamtaufwandes eines Data-Mining-Projektes. Insgesamt hilft das CRISP-DM-Modell dabei, Data Mining-Projekte systematisch und effizient zu planen und durchzuführen, was zu besseren Ergebnissen führt.

Literatur

Baars, H., Kemper H. (2020). Business Intelligence & Analytics – Grundlagen und praktische Anwendungen. Springer Vieweg

Hinweis

Dieser Blog–Beitrag wurde mit Unterstützung von KI erstellt.