Parallele Programmierung ist der Schlüssel, um zeitintensive Aufgaben effizienter zu lösen. Indem grosse Aufgaben in kleinere Teilaufgaben zerlegt und gleichzeitig bearbeitet werden, können Rechenressourcen optimal genutzt werden. Mit der Parallelisierung steigt jedoch auch die Komplexität und damit die Gefahr von Fehlern wie Deadlocks oder Race Conditions. Erfahre, wie parallele Programmierung funktioniert, welche Vorteile sie bietet und worauf es ankommt.

Warum parallele Programmierung?

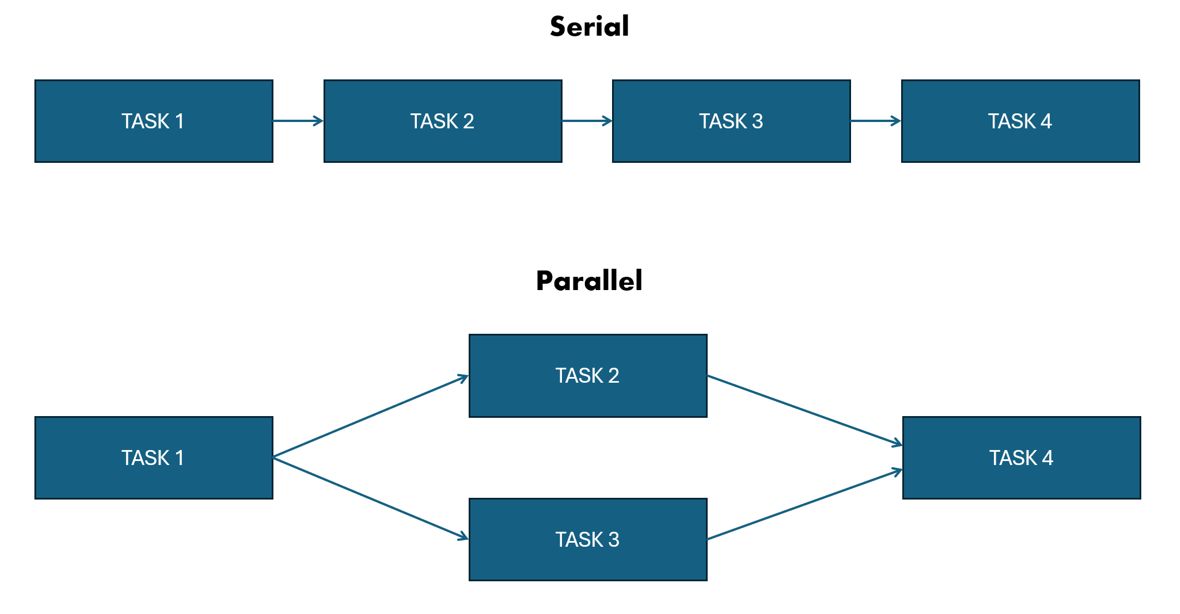

In der Softwareentwicklung gibt es oft Aufgaben, die nacheinander (synchron) ausgeführt werden und viel Zeit beanspruchen. Parallele Programmierung schafft hier Abhilfe: Sie ermöglicht es, Aufgaben in kleinere Teile aufzuteilen und gleichzeitig auszuführen. Das spart Zeit und nutzt moderne Mehrkernprozessoren optimal.

Wie funktioniert parallele Programmierung technisch?

Parallelität erfordert Unterstützung durch die Hardware. Moderne CPUs mit Multithreading oder Mehrkernprozessoren ermöglichen die gleichzeitige Ausführung mehrerer Threads oder Prozesse. Programmiersprachen wie Java oder Python bieten Werkzeuge, um diese Parallelität umzusetzen. Dabei wird oft mit Threads gearbeitet, die separate Aufgaben parallel bearbeiten.

Herausforderungen

Trotz der Vorteile bringt parallele Programmierung einige Herausforderungen, die bedacht werden müssen wie zum Beispiel:

- Speicherprobleme

Parallellaufende Threads können den Arbeitsspeicher stark beanspruchen. Wenn Speicherzugriffe nicht effizient gehandhabt werden, kann es zu Cache Invalidierung kommen, was die Performance drastisch reduziert. - Kommunikation zwischen Threads

Threads, die miteinander kommunizieren müssen, reduzieren die Parallelität, da sie aufeinander warten können. - Deadlocks

Fehler können auftreten, wenn die Reihenfolge von Threads nicht korrekt definiert ist. Beispielsweise können zwei Threads gegenseitig aufeinander warten, wodurch ein Deadlock entsteht und das Programm nicht mehr weiterläuft. - Zugriff auf geteilte Ressourcen

Wenn mehrere Threads dieselbe Ressource nutzen, können Race Conditions entstehen. Um solche Fehler zu vermeiden, werden Synchronisationsmechanismen wie

Mutex, Semaphoren oder Barrieren eingesetzt. Alternativ ermöglichen Rendezvous-Mechanismen kontrollierte Zusammenarbeit zwischen Threads. - Umgang mit Threads

Das Erstellen und Zerstören von Threads kann ressourcenintensiv sein, insbesondere bei vielen kleinen Aufgaben. Um diesen Aufwand zu reduzieren, kommen Thread Pools zum Einsatz.

Thread Pools: Hier werden Threads einmalig erstellt und für mehrere Aufgaben wiederverwendet. Dadurch reduziert sich der Overhead erheblich. Dieser Ansatz ist besonders effektiv in Anwendungen, die eine hohe Anzahl paralleler, aber kurzlebiger Aufgaben bewältigen müssen.

Vorteil

Der grösste Vorteil der parallelen Programmierung liegt in der erheblichen Zeitersparnis bei der Ausführung rechenintensiver oder zeitkritischer Aufgaben. Durch die gleichzeitige Verarbeitung mehrerer Teilaufgaben wird die verfügbare Rechenleistung optimal genutzt, was insbesondere bei modernen Mehrkernprozessoren zu einer deutlich höheren Effizienz führt.

Nachteil

Parallelität bringt einen erhöhten Programmieraufwand mit sich.

Entwickler müssen:

- Den Zugriff auf Variablen und Ressourcen sorgfältig synchronisieren.

- Fehler, die durch Parallelität entstehen, identifizieren und beheben. Das Debuggen solcher Fehler ist oft schwierig.

Zeitvorteil

Wie viel Zeit durch parallele Programmierung eingespart werden kann, hängt stark von der Art der Aufgabe ab:

- Höherer Workload: Bei komplexen Aufgaben mit grossem Rechenaufwand zeigt sich die Stärke der Parallelisierung.

- Geringer Workload: Bei weniger aufwendigen Aufgaben überwiegt der Overhead der Parallelisierung, was zu längeren Ausführungszeiten im Vergleich zur sequentiellen oder asynchronen Ausführung führen kann.

Ein Beispiel verdeutlicht dies: Ein Autor entwickelte ein Programm, das Daten von einer URL abruft, und verglich dabei verschiedene Ansätze: synchron, asynchron und parallel Implementierung. Die parallele Implementierung war in jedem Szenario schneller als die synchrone, unabhängig davon, ob sie mit oder ohne Asynchronität kombiniert wurde. In diesem Blogbeitrag wurde die asynchrone Parallelität nicht thematisiert, weshalb asynchrone Implementierungen hier keine weitere Betrachtung finden.

Fazit

Parallele Programmierung ist ein mächtiges Werkzeug. Sie erfordert jedoch ein fundiertes Verständnis für potenzielle Fehlerquellen und deren Vermeidung. Entwickler, die diese Technik sorgfältig einsetzen, können die Effizienz ihrer Anwendungen deutlich steigern.