Sensible Daten gehören zum Arbeitsalltag: Logs, Code, interne Dokumente oder E-Mails. Viele KI-Tools versprechen Unterstützung, verlangen dafür aber genau diese Daten in der Cloud. Gleichzeitig werden lokale KI-Modelle immer leistungsfähiger und beliebter. In diesem Beitrag zeige ich, wie kleine, lokal betriebene KI-Modelle heute schon produktiv eingesetzt werden können – sicher, effizient und alltagstauglich. Besonders in der Schweiz gewinnt dieser Ansatz an Bedeutung.

Warum ich lokale KI überhaupt testen wollte

Im Berufsalltag entstehen viele Situationen, in denen KI helfen könnte – etwa beim Analysieren von Fehlermeldungen, beim Strukturieren von Texten oder beim Vorbereiten von Aufgaben. Gleichzeitig sind genau diese Inhalte oft sensibel. Sie externen Cloud-Diensten anzuvertrauen, ist nicht immer erlaubt.

Lokale KI-Modelle lösen dieses Spannungsfeld: Sie laufen direkt auf dem eigenen Gerät, die Daten verlassen das System nicht. Dadurch sinkt die Hemmschwelle, reale Arbeitsinhalte einzusetzen. Gerade in der Schweiz, wo Datenschutz und Vertraulichkeit eine zentrale Rolle spielen, wird KI so erst wirklich alltagstauglich.

Wie ich lokale KI konkret nutze – meine Erfahrungen

Im Alltag als Softwareentwickler und IT-Projektleiter setze ich lokale KI gezielt für kurze, klar umrissene Aufgaben ein:

- Coding & Debugging: Einordnen von Fehlermeldungen und Optimieren einzelner Codeabschnitte.

- Daten & SQL: Verstehen und Verbessern von Abfragen.

- Planung & Kommunikation: Formulieren und Strukturieren von Jira-Tickets, User Stories und E-Mails.

- Ideenfindung: Brainstorming und erste Entwürfe

Für viele dieser Aufgaben reichen bereits sehr kleine Modelle aus. Sie sind schnell, fokussiert und lassen sich ohne zusätzlichen Prozessaufwand in den Arbeitsalltag integrieren.

Meine Testumgebung – erstaunlich genügsam

Ich habe Modelle auf zwei Geräten getestet:

- Lenovo-Laptop mit 18 GB shared VRAM

- Desktop-PC mit einer älteren GTX 1080

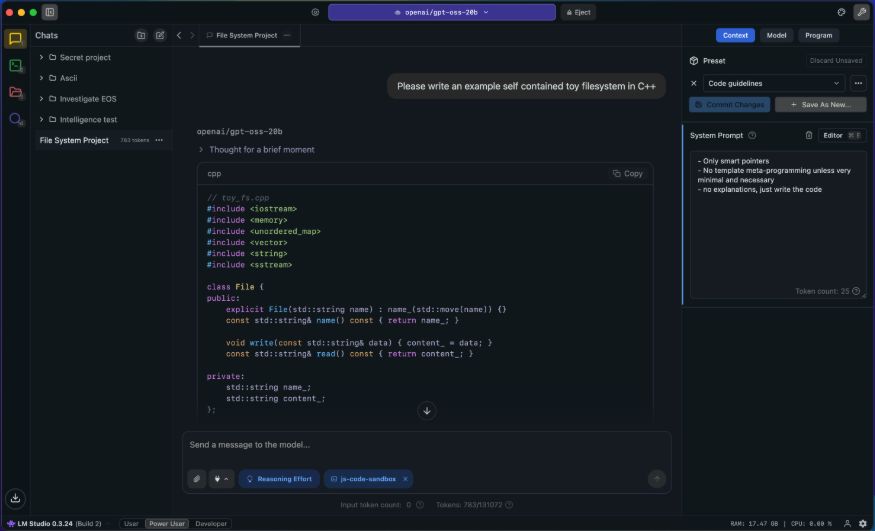

Als Tools nutze ich LM Studio oder Ollama mit OpenWebUI. Beide funktionieren zuverlässig, im Alltag greife ich jedoch häufiger zu LM Studio. Der Grund ist die sehr einfache Bedienung: Neue Modelle lassen sich dort mit einem Klick herunterladen, starten und direkt vergleichen.

Das Interface zeigt übersichtlich, wie stark ein Modell das System beansprucht, wie schnell es antwortet und wie gross das verfügbare Kontextfenster ist. Diese Transparenz hilft enorm, um einzuschätzen, welches Modell zur eigenen Hardware passt und wo technische Grenzen liegen.

Das Ergebnis hat mich positiv überrascht: Viele Modelle laufen flüssig, reagieren schnell und lassen sich unkompliziert testen und austauschen.

Entscheidend für den Nutzen ist neben der Hardware vor allem die Wahl des Modells.

Welche Modelle mich am meisten überzeugt haben

In meinen Tests haben mich vor allem kleinere, spezialisierte Open-Source-Modelle überzeugt, etwa:

- Allround-Modelle für Zusammenfassungen und allgemeine Aufgaben

- Reasoning-Modelle für logische Analysen

- Coding-Modelle für Debugging und Coding

- Spezialisierte Modelle für SQL-Abfragen

Die meisten Modelle erscheinen in mehreren Grössen und lassen sich gut an die vorhandene Hardware anpassen. Was früher leistungsstarke GPU-Systeme erforderte, funktioniert heute oft auf einem normalen Laptop.

Wo ich beim lokalen Einsatz an Grenzen stosse

Meine Tests haben aber auch gezeigt, wo die Limitierungen liegen:

- Sehr grosse Eingaben sprengen schnell das Kontextfenster

- Begrenzte Hardware wirkt sich bei längeren oder komplexeren Aufgaben auf die Qualität aus.

-

Kleine Modelle liefern gute Ergebnisse – bis sie zu viel auf einmal verarbeiten müssen.

Trotzdem decken lokale Modelle einen grossen Teil typischer Wissensarbeits-Aufgaben ab, insbesondere bei kurzen, klaren Inputs.

Warum lokale KI zur Schweiz passt und warum sie wachsen wird

In der Schweiz sind Datenschutz und Vertraulichkeit besonders wichtig. Lokale KI erfüllt diese Anforderungen, da sensible Daten das eigene System nicht verlassen. Gleichzeitig werden Open-Source-Modelle immer effizienter. Die Entwicklung zeigt klar: Kleine, lokale KI wird ein fester Bestandteil der täglichen Arbeit werden.

Fazit

Meine Tests zeigen: Lokale KI ist heute schon ein vollwertiges Arbeitswerkzeug. Kleine Open-Source-Modelle laufen auf normaler Hardware, helfen beim Coding, analysieren Logs, fassen Texte zusammen und unterstützen bei kreativen Aufgaben – alles ohne Cloud und ohne Datenabfluss.

Besonders in der Schweiz hat diese Form der KI enormes Potenzial: Sie vereint Sicherheit, Effizienz und Unabhängigkeit und macht KI dort nutzbar, wo sie wirklich gebraucht wird.

Weiterführende Links

- Einführung in lokale Large Language Models: https://huggingface.co/docs

- Lokale KI-Modelle einfach testen: https://lmstudio.ai

Dieser Blog-Beitrag wurde mit Unterstützung lokaler KI erzeugt.