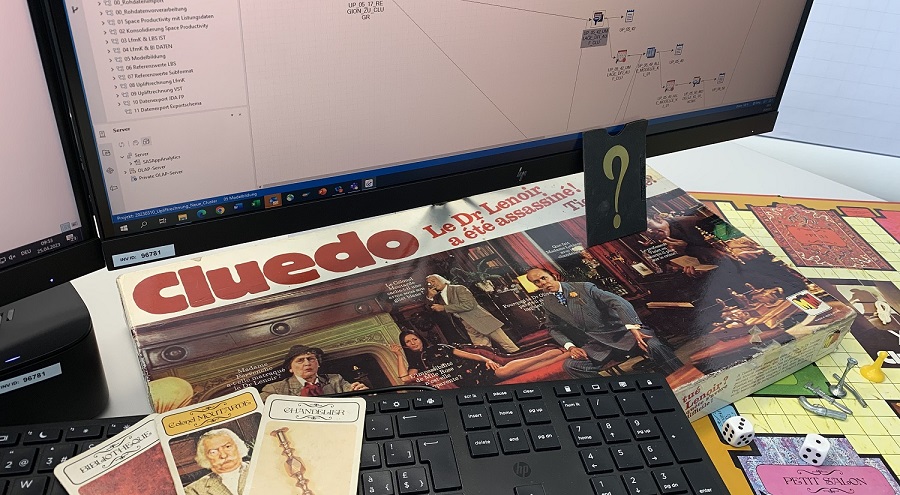

Der Einsatz von Prognosemodellen ist nützlich, aber auch tückisch. Modellprognosen können unplausibel sein, wenn sie zum Beispiel gegenüber den Erfahrungswerten deutlich zu hoch oder zu tief ausfallen. Auch erfahrene Analysten werden bei der Fehlersuche herausgefordert, wenn der Datenverarbeitungsprozess komplex ist. Systematische Herangehensweisen erweisen sich als erfolgversprechend. Dabei zeigt sich eine Analogie zum Detektivspiel Cluedo.

Beim Detektivspiel Cluedo geht es im Kern darum, einen Mordfall zu lösen, indem durch geschickte bzw. systematische Fragetechnik der Täter oder die Täterin, die Tatwaffe und der Tatort identifiziert werden. «Mordfälle» bei Datenverarbeitungsprozessen werden mit einer ähnlichen Systematik gelöst:

Zuerst «Mordopfer» finden und obduzieren

Wenn Prognosemodelle eingesetzt werden, lassen sich die prognostizierten Werte gut mit den Erfahrungswerten vergleichen. Ein Beispiel ist das Schätzen des Abhängigkeitsverhältnisses zwischen der Sortimentsbreite und den erzielten Verkaufserlösen in Supermärkten. Wenn bei einer realitätsnahen Variation der Sortimentsbreite die prognostizierten Erlöse ein Niveau erreichen, das bisher noch nie beobachtet wurde, sind die Prognosewerte unplausibel und ein «Verbrechen» muss gelöst werden. Unplausible Prognosen lassen sich zumeist leicht erkennen und eingrenzen. Wenn nur ein bestimmter Sortimentsteil betroffen ist, muss nur ein einfacher Mord gelöst werden, der unter ganz bestimmten noch zu klärenden Bedingungen geschah. Wenn gleich massenhaft Morde über mehreren Sortimentsteile vorliegen, ist das zwar wegen des Umfangs unerfreulich, die dahinterliegende Systematik lässt sich aber erfahrungsgemäss einfach erkennen.

Tatort ermitteln

Das Mordopfer ist bekannt: Ein bestimmtes Teilsortiment liefert bei einer bestimmten Sortimentsbreite unplausible Prognosewerte. Somit kann mittels Stichproben der gesamte Datenverarbeitungsprozess untersucht werden. Es könnte ein fehlerhafter Input für die Modellschätzung vorliegen, eventuell ist aber auch ein nachträglicher Bereinigungs- oder Aggregationsschritt für den Mord verantwortlich. Es geht also zuerst darum, den Tatort zu ermitteln. Ein thematisch gut gegliederter Datenverarbeitungsprozess mit einer überschaubaren Anzahl Kapitel ist von Vorteil, da damit die Stichprobenziehung thematisch gezielter angesetzt werden kann. Das ist vergleichbar mit den 9 Räumen in der ursprünglichen Version von Cluedo (z. B. Eingangshalle, Küche, Arbeitszimmer, etc.).

Täter erkennen

Im Gegensatz zu Cluedo muss der Tatort zuerst ermittelt werden und der Täter bleibt immer am Tatort. Dadurch verengt sich der Kreis der Tatverdächtigen markant. Als Täter kommen die einzelnen Abfrageknoten infrage. Mehrere analytische Tools verwenden eine grafische Benutzeroberfläche, bei der Datenflüsse durch Linien und Tabellenoperationen in Knoten gebündelt werden (Beispiele: KNIME, IBM SPSS Modeler oder SAS Enterprise Guide); Hier sind die visuell gut abgebildeten Abfrageknoten potenzielle Täter. Manchmal ist es das Zusammenspiel aus mehreren Abfrageknoten, die zur Mordtat führen. Man kann dabei auch von Komplizenschaft sprechen.

Tatwaffe finden

Die Ermittlung des Täters und der Tatwaffe erfolgt zumeist in kurzem Abstand. Als Tatwaffen kommen vor allem Tabellenoperationen infrage: Selektionen von Zeilen oder Spalten, Aggregationen, Tabellenverbindungen, Generierung neuer Spalten und Sortierungen. Häufig kommt es zu falschen Verdächtigungen: Ein Abfrageknoten wird identifiziert, bei dem ein Problem offensichtlich wird; Die Ursache liegt aber häufig bei einem eher unauffälligen Input, der von einem weiter zurückreichenden Abfrageknoten stammt. Der Auftragsmörder hält sich dabei im Dunkeln versteckt. Ein Beispiel sind Duplikate von Prognosewerten aufgrund von unzureichenden Tabellenverbindungen. Erst bei der Datenaggregation wird der Fehler offensichtlich, wenn sich bei einer Summierung die Prognosewerte vervielfachen.

Datendetektive sichern Datennutzung

Je jünger ein komplexer Datenverarbeitungsprozess ist, desto häufiger treten Morde auf, da dann noch viele bisher unbemerkte Fehler und suboptimale Bereinigungsprozeduren bestehen. Je reifer ein Datenverarbeitungsprozess ist, desto eher hat man es mit Ausnahmefällen oder vereinzelten Fehlern bei den Inputdaten oder Stammdaten zu tun. Auch diese Ausnahmefälle müssen lückenlos aufgeklärt werden, da Entscheidungsträger aufgrund von vereinzelten unplausiblen Werten die Gesamtheit der Prognosewerte infrage stellen. Systematische Detektivarbeit lohnt sich also, führt zu einer sehr guten Datenqualität und macht auch Spass – ähnlich wie das Detektivspiel Cluedo.