„Nach Schätzungen verursacht schlechte Datenqualität in Unternehmen Verluste von bis zu 25% des operativen Gewinns“, gemäss Crosby 1979 / Juran 1988! Daten sind der Rohstoff des 21. Jahrhunderts. Unternehmen / Institutionen geben Millionen für die Erfassung, Aufbereitung und Auswertung von Daten aus. Nur was, wenn die Datenqualität nicht passt?

Datenqualität dürfte im Altertum / Mittelalter schon eine knifflige Aufgabe gewesen sein, als Daten für Volkszählungen, Zoll- und Steuerthemen erhoben wurden. Auch 1000, respektive 2000 Jahre später, steht das Thema im Rampenlicht. Zunehmende Digitalisierung, unstrukturierte Daten, Compliance & Co lassen die Komplexität der Business Case explodieren und die Anforderungen an die Datenqualität immer anspruchsvoller werden!

So bekommst Du die Datenqualität in den Griff!

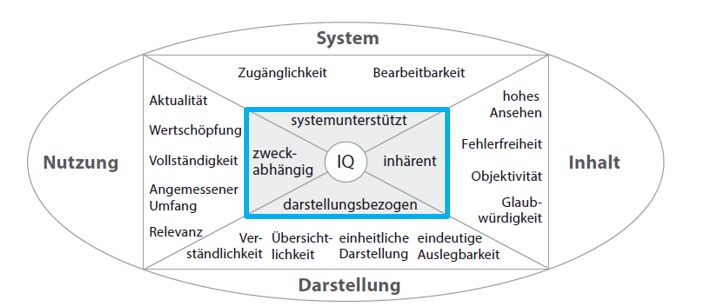

Qualitätsmerkmale wie Vollständigkeit, Genauigkeit, Redundanzfreiheit etc. bilden die Basis erfolgreicher Business Analysen! Akkurat aufbereitet und verständlich dargestellt sind sie ein Garant für fundierte und fokussierte Ergebnisse.

Transparenz schafft Vertrauen in Deine Zahlen! Das setzt voraus, dass die Ergebnisse nachvollziehbar sind. Das gilt für externe wie für interne Datenquellen. Die verschiedenen Umwandlungen der Daten müssen transparent und rückverfolgbar sein. Das gilt für die ganze Prozesskette der Datenaufbereitung (Erfassung bis Auswertung).

Prozess-Monitoring zeigt das Verbesserungspotential von Euren Prozessen, Tools, etc., präzise auf. Erfahrungsgemäss kommen fehlerhafte Daten oft erst bei den Analysen an die Oberfläche. Hintergrund ist die verdichtete Betrachtungsmöglichkeit der Daten in Statistiken. Wir bekamen schon 7stellige Beträge gutgeschrieben – dem Prozess Monitoring sei Dank!

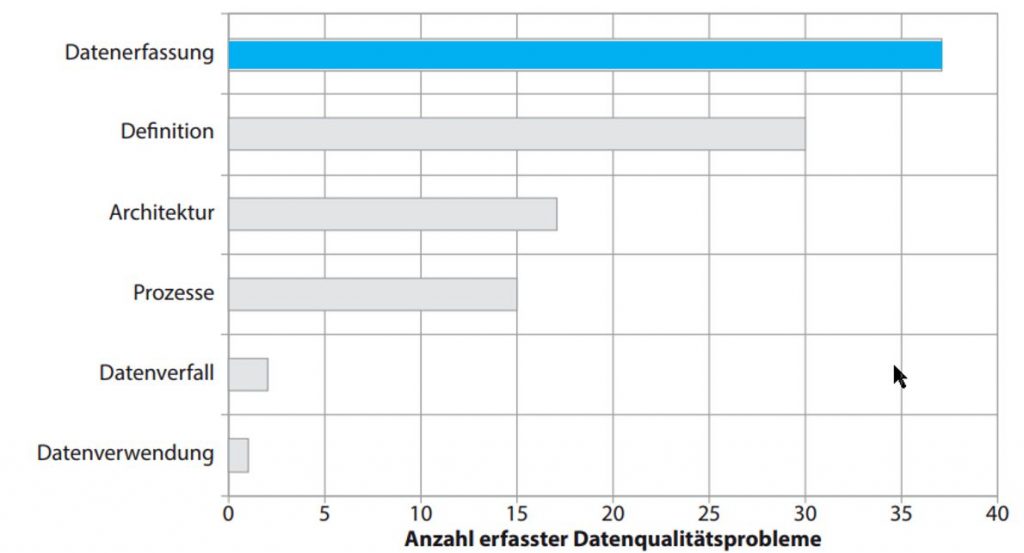

Wo der Schmerz am grössten ist!

Vertrauensverluste in die eigenen Daten entsteht in vielen Fällen durch ungenügende Datenqualität! Oft der Ursprung für endlose Diskussionen – welcher Business Analyst kennt das nicht. Der Zeitaufwand für die Richtigstellung ist nicht zu unterschätzen: wir (BI Team Festo) verbringen regelmässig Stunden, um die Ursachen falscher Daten zu klären, BUG’s beheben zu lassen. Dies führt letztendlich zu grossen Verzögerungen und aufgeschobenen Entscheidungen.

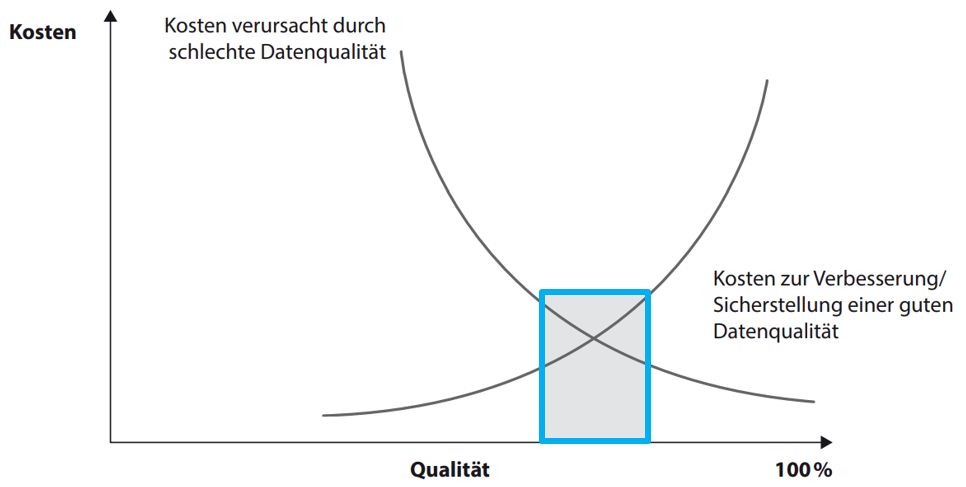

Kostentreiber Datenqualität Frühzeitiges identifizieren / eliminieren von Datenqualitätsproblemen reduzieren das operative Risiko massgeblich. Oft werden bei BA Projekten leider nur mangelnde Budget zur Sicherstellung der Q Massnahmen gesprochen. Die Erfahrung zeigt: präventives Einrichten von adäquaten Q Massnahmen generiert weniger Kosten als die verursachten Auswirkungen mangels fehlender Datenqualität – im Schnitt sind die Kosten ca. 2/3 geringer!

Datenerfassung „Die initiale Dateneingabe ist eine der wesentlichsten Ursachen für das Auftreten schlechter Datenqualität“. Die Ursachen für Fehler bei der Erfassung der Daten sind vielfältig:

- falsche Dateneingabe

- mangelndes Design der Eingabemasken

- unvollständiges Erfassen aufgrund fehlender Informationen

- mangelndes Bewusstsein der Mitarbeiter: was bedeutet ein fehlerhaftes Erfassen für die übergeordnete Ebene

Wichtig ist, dass bereits bei der Datenerfassung die Bedürfnisse des Unternehmens in die Überlegungen zur Sicherstellung der Datenqualität einfliessen – nur aus der gesamtheitlichen Sichtweise lassen sich die relevanten Massnahmen ableiten.

Komprimiert „Datenqualität ist keine Einmal-Aktion, sondern muss als Daueraufgabe angesehen werden“. Erfolgreiche Business Intelligence Projekte legen die erforderlichen Q Kriterien, abgestimmt auf den Business Case und den passenden Ansprüchen, jeweils im Vorfeld fest. Dies unter Einbezug der Anwender – so schaffst Du das notwendige Verständnis / Vertrauen in Deine Analyse.

Die Q-Kriterien auf einen Blick! (Bildquelle: Aple, Behme, Eberlein 2015, S. 11“)