Eine Fremdsprache lernen ist aufwändig. Das Paretoprinzip und Big Data können uns unterstützen.

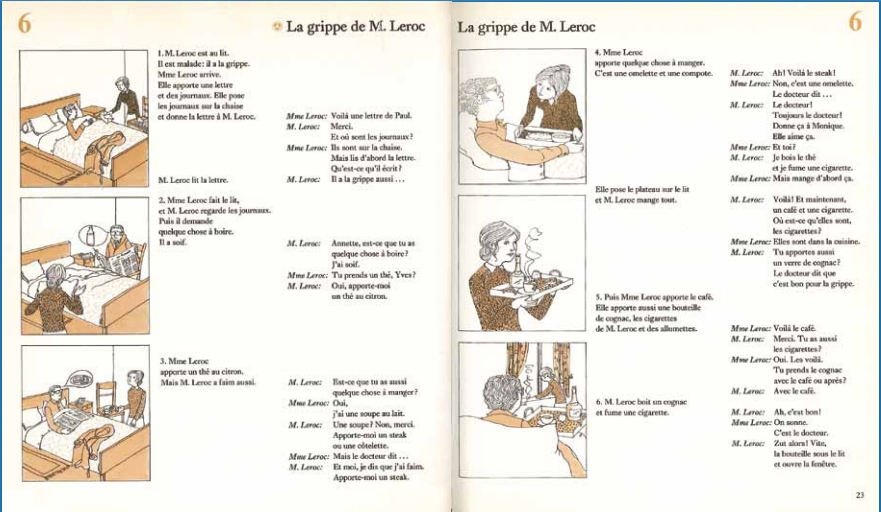

Frühfranzösisch – Vokabeln büffeln – Mr. und Mme Leroc – Es war nie meine «grand amour» sondern «je ne comprends pas».

Irgendwann entschied ich mich, eine Lehre in einem technischen Bereich zu absolvieren – Französisch ist dafür unnütz. Mit dieser Einstellung wurde mein persönlicher Aufwand für das Fach Französisch auf ein Minimum reduziert. Für eine genügende Note reichte es noch knapp. Nach Lehre, Studium und den ersten Berufsjahren schien meine Strategie bezüglich des Minimalismus gegenüber dieser Sprache aufzugehen.

La Suva – Mieux qu’une assurance

Doch plötzlich arbeitete ich nicht mehr für einen internationaler Brötchengeber, sondern für die Schweizer Unfallversicherungsanstalt Suva – Französisch war gefragt. Ich grub meine spärlichen Kenntnisse aus, rundete dies mit einem Kurs der Klubschule Migros ab. Wie bei solchen Veranstaltungen üblich, sind die Teilnehmer/innen bunt zusammengewürfelt. Der Pensionierte lernt fürs Reisen, die Dame will ihren Freund aus der Elfenbeinküste besser verstehen und ich der Suva Agentur in Lausanne Finessen der Unfallversicherung näherbringen. Eine breite Anforderungspalette an die Lehrerin und an den zu vermittelnden Wortschatz. Am Ende reichte es für ein bisschen Small Talk. Der Erwerb des spezifischen Wortschatzes einer Unfallversicherung blieb verständlicherweise auf der Strecke.

«Eitel ist, etwas mit mehr zu erreichen, was mit weniger erreicht werden kann», Wilhelm von Ockham

Das Anwenden des Paretoprinzips beim Lernen einer Fremdsprache

Im CAS «Big Data Analytics» brachte man uns im Modul «Data Science» auch Natural Language Processing (NLP) näher. «Fasziniert von der Möglichkeit aus einem riesigen Wörterhaufen die Häufigkeit der Wörter zu ermitteln, erinnerte ich mich an eine Idee auf welche ich einmal im Internet gestossen bin: «Das Anwenden des Paretoprinzips beim Lernen einer Fremdsprache». Oder, zuerst diejenigen Wörter lernen, welche man am häufigsten verwendet.

Es gibt im Internet bereits viele Wortlisten, welche auf dem Paretoprinzip basieren. Nachfolgend zwei Beispiele:

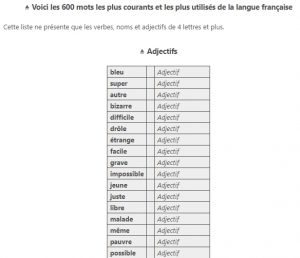

Die 600 meist verwendeten Wörter auf Französisch

http://www.encyclopedie-incomplete.com/?Les-600-Mots-Francais-Les-Plus

Einige dieser Wörter sind z.B. bleu, super, drôle, truc oder président.

Liste der rechtschreiblich schwierigen Wörter auf Deutsch

https://www.duden.de/Liste-der-rechtschreiblich-schwierigen-Woerter

In meinem konkreten Fall angewendet heisst dies, den Fokus auf den speziellen französischen Wortschatz meines Arbeitsumfeldes zu legen und diese Wörter prioritär zu lernen.

Als Tarifierungsexperte der Suva bestimme ich u.a. die Prämiensätze der Branchen Mikro- , Medizinaltechnik und Elektrotechnik. Die Unternehmen deklarieren eine Betriebsbeschreibung damit diese von meinen Arbeitskollegen oder mir der richtigen Branche zugeteilt werden. Die Zuteilung der Branche ist ein gewichtiger Faktor für das Festlegen des korrekten Prämiensatzes. Teil der Betriebsbeschreibung ist die Tätigkeitsbeschreibung welche branchenspezifischen Worte beinhaltet.

Solche Tätigkeitsbeschreibungen sind z.B.

- «Inbetriebnahme von Leitsystemen (Steuerung), verfassen von Dokumentationen, Schulungen»

- «Recherche, développement, fabrication et promotion de systèmes optiques»

- «Exploitation d’un établissement pour soins dentaires et travaux de laboratoire»

Den Wortschatz dieser Texte besser zu verstehen ist mein Ziel.

Jetzt die Umsetzung mit R Studio

Für die Umsetzung musste ich das Wissen von Natural Language Processing mit dem Fachknowhow kombinieren und im R Studio ein paar Zeilen Code schreiben. Die Tätigkeitsbeschreibungen organisierte ich mir aus dem Data Warehouse der Suva und schrieb diese in ein CSV-File. Die generierte Wortliste exportierte ich in ein Excel-File zum Weiterbearbeiten.

Folgende französische Wörter werden in den Tätigkeitsbeschreibungen am häufigsten verwendet:

| Rang 1 -25 | Wort | Häufigkeit | Rang 26 -50 | Wort | Häufigkeit |

| 1 | fabrication | 527 | 26 | électroniques | 65 |

| 2 | bureau | 441 | 27 | mouvements | 59 |

| 3 | vente | 320 | 28 | production | 58 |

| 4 | montres | 233 | 29 | bijoux | 56 |

| 5 | réparation | 232 | 30 | montage | 56 |

| 6 | développement | 182 | 31 | administration | 55 |

| 7 | appareils | 171 | 32 | polissage | 54 |

| 8 | produits | 149 | 33 | machines | 50 |

| 9 | horlogerie | 140 | 34 | instruments | 47 |

| 10 | assemblage | 130 | 35 | installations | 43 |

| 11 | dentaire | 110 | 36 | achat | 42 |

| 12 | composants | 105 | 37 | pose | 42 |

| 13 | laboratoire | 105 | 38 | bijouterie | 41 |

| 14 | horlogers | 102 | 39 | recherche | 41 |

| 15 | entretien | 92 | 40 | systèmes | 41 |

| 16 | atelier | 88 | 41 | création | 40 |

| 17 | commerce | 86 | 42 | électronique | 39 |

| 18 | pièces | 86 | 43 | boîtes | 37 |

| 19 | commercialisation | 85 | 44 | cadrans | 37 |

| 20 | installation | 83 | 45 | sertissage | 37 |

| 21 | électriques | 77 | 46 | horlogère | 34 |

| 22 | conception | 71 | 47 | matériel | 34 |

| 23 | domaine | 70 | 48 | réparations | 33 |

| 24 | technique | 69 | 49 | bureaux | 32 |

| 25 | service | 67 | 50 | sous | 32 |

Die Aussage, «den Fokus beim Lernen auf die am häufigsten verwendeten Wörter zu legen» ist ein Hohn für Linguisten und die meisten Liebhaber/innen der Französischen Sprache. Das Lernen einer Sprache besteht nicht nur aus dem Büffeln von Vokabeln. Oder wie auf der Seite «Les-600-Mots-Francais-Les-Plus» zu lesen ist: Un «érudit» utilise courament quelques 15000 mots différents… Für mich als Ingenieur, eher der pragmatischen Seite zugewandt, ist dies aber eine Option meinen Wortschatz zu erweitern. Damit kann ich mit wenig Lernaufwand meine Aufgabe im Berufsalltag optimal erfüllen.

Für Interessierte die sich in den Code vertiefen möchten

Interessierte finden nachfolgend den Code in R. Ich bin überzeugt, auch diesen Code kann man eleganter schreiben. Aber auch hier lag das Paretoprinzip im Fokus. Vielleicht wäre das Ermitteln der häufigsten R-Befehle ein Thema für einen weiteren Blog? Anstelle von «Fremdsprachen lernen mit Big Data?» wäre es dann «R lernen mit Big Data?»

# Packages installieren

install.packages(„tm“)

install.packages(„tau“)

install.packages(„plyr“)

install.packages(„dplyr“)

install.packages(„textcat“)

install.packages(„readr“)

install.packages(„SnowballC“)

install.packages(„xlsx“)

# Libraries laden

library(tm)

library(tau)

library(plyr)

library(dplyr)

library(textcat)

library(readr)

library(SnowballC)

library(xlsx)

# Stoppwörter entfernen (T für JA / F für Nein)

stop_words <- T

# CSV-File auswählen im Format „UTF-8“

# Basis des CSV-File ist ein Excel-File mit einem Spaltentitel „TAETIGKEIT“

# Jede Zeile dieser Spalte beinhaltet einen Tätigkeitsbeschrieb eines Unternehmens

# Das Excel-File wird als CSV-File (UTF-8) gespeichert

data <- read.csv(file.choose(), header = TRUE, sep = „;“, encoding = „UTF-8“)

# Spalte „TAETIGKEIT“ in den Datentyp „Character“ umwandeln

data$TAETIGKEIT <- as.character(data$TAETIGKEIT)

# Spalte „TAETIGKEIT“ in einen Vector „Sprache“ kopieren

Sprache <- as.vector(data$TAETIGKEIT)

# Sprache des Vectorinhaltes erkennen und in den Vector schreiben

Sprache <- textcat(Sprache)

# Vector „Sprache“ in ein Dataframe ändern und dieses mit dem Dataframe „data“ verbinden

Sprache <- data.frame(Sprache)

data <- data.frame(data, Sprache)

# Filtert das Dataframe nach Text in französischer Sprache

data <- filter(data, Sprache == „french“)

# Die einzelnen Inhalte der Spalte „TAETIGKEIT“ mit einem “ “ trennen.

data <- paste(data$TAETIGKEIT, collapse=“ „)

# Stopwörter in der Spalte „TAETIGKEIT“ entfernen und die Wörter in Einzelwörter zerlegen

data <- tau::textcnt(

if(stop_words==T) {tm::removeWords(tm::scan_tokenizer(data), tm::stopwords(„french“))}

else {

tm::scan_tokenizer(data)

}

, method = „string“, n = 1L, lower = 1L)

# Liste in ein Dataframe ändern

data <- plyr::ldply(data, data.frame)

# Zeilen des Dataframes benennen

colnames(data)<-c(„WORT“, „HAEUFIGKEIT“)

# Spalte „HAEUFIGKEIT“ des Dataframes absteigend sortieren

data <- arrange(data, desc(HAEUFIGKEIT))

# Dataframe in ein Excelfile mit dem Namen „Wortliste.xlsx“ schreiben

write.xlsx(data, „Wortliste.xlsx“)