EU AI Act: Warum die Nachvollziehbarkeit von KI-Ergebnissen entscheidend ist

Experteninput von Philippe Hovaguimian und Präsentation von Sarah Hauser zum Thema KI und Hochschulen, 25. September 2023

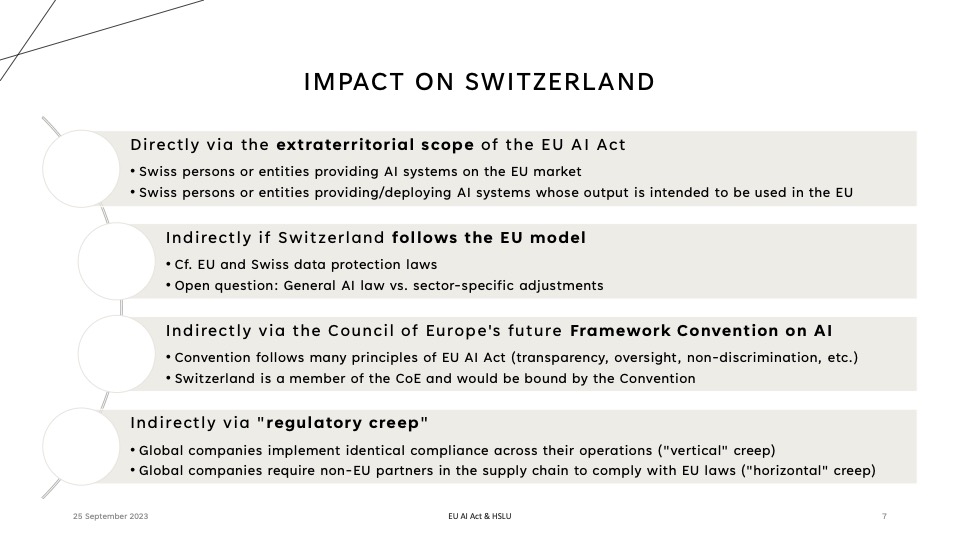

Die HSLU I wird künftig mit grosser Wahrscheinlichkeit sicherstellen müssen, dass Personen, welche von KI-Entscheiden betroffen sind, über den Prozess informiert werden und sie sich darüber informieren können, wie die Entscheidungen getroffen wurden. Das gilt namentlich für KI-gestützte Zulassungsprozesse an Hochschulen, wie auch für KI-gestützte Prognosen oder Bewertungen von/über Studierende/n, inklusive bei der Ermittlung von unerlaubtem Prüfungsverhalten. Das Gesetz wird auch für in der Schweiz ansässige KI-Anbieter und Nutzende Bedeutung haben – z.B. dann, wenn Schweizer KI-Produkte in der EU angeboten werden oder wenn EU-Bürger durch einen generierten Output von Schweizer KI-Anwendungen betroffen sind.

Folie aus dem Experteninput von Philippe Hovaguimian

Folie aus dem Experteninput von Philippe Hovaguimian

Wie gehen wir aktuell an der HSLU I mit KI-Anwendungen um?

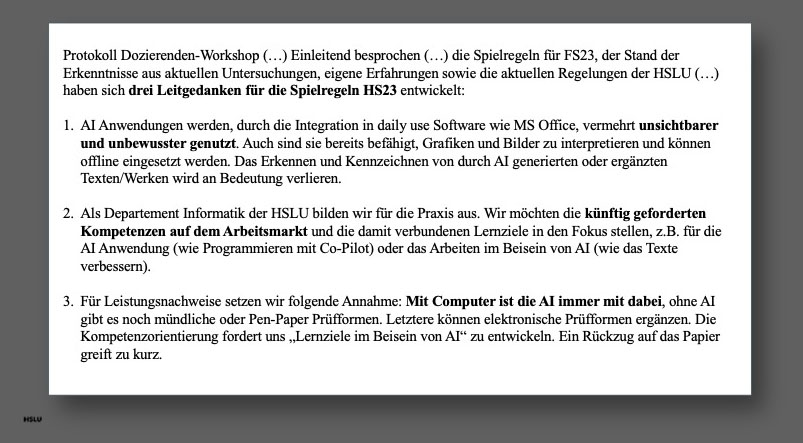

Im Umgang mit KI bilden die drei Leitgedanken der HSLU I die aktuell Grundlage für die Ausbildung. Sie unterstreichen die ubiquitäre Nutzung und die Bedeutung von KI-Kompetenzen für die künftige Berufspraxis der Studierenden. Ausserdem, das Prüfungsportfolio der Hochschule wird mit neuen Formen ergänzend ausgestaltet werden müssen.

Drei Leitgedanken zu KI an der HSLU I, Sarah Hauser

Drei Leitgedanken zu KI an der HSLU I, Sarah Hauser

Der Fokus der aktuellen HSLU I-Leitlininen auf Kompetenzen (statt beispielsweise auf KI-Verbote) werden durch den EU AI Act bestätigt: Der Act misst der AI-Literacy grosse Wichtigkeit zu, indem er verlangt, dass Bildungsmassnahmen ergriffen werden, um die KI-Literacy der Bevölkerung zu erhöhen. Es soll sichergestellt werden, dass die Kontrolle über KI-Systeme nicht der technologischen Elite vorbehalten ist.

EU AI Act – worum geht es?

Der EU AI Act ist ein Gesetz der Europäischen Union zur Regulierung von KI-Systemen. Es soll sicherstellen, dass bestimmte Standards in Bezug auf Transparenz, menschliche Aufsicht und repräsentative Trainingsdaten bei KI erfüllt sind. Das Gesetz befindet sich derzeit im Entwurfsstadium – die Entwicklung wird bis Ende 2023 oder bis 2024 dauern.

EU AI Act und Hochschulen

Eine persönliche, nicht-professionelle Nutzung von KI, wie beispielsweise beim Einsatz von KI-Systemen durch die Studierenden selbst, fällt nicht unter den EU AI Act. Andere, professionelle Nutzungen im Bildungsbereich (nämlich bei der Zulassung, Bewertung und Überwachung von Studierenden) können jedoch als sogenannte „Hochrisiko“-KI-Systeme gelten und unterliegen dann strengen Auflagen, die unter anderem Datenqualität, Transparenz, menschliche Aufsicht und Folgenabschätzungen für die Grundrechte vorsehen. Hier stellt sich allerdings bereits jetzt die Frage, wie Kontrollbehörden die Qualität in diesen Bereichen sicherstellen können.

Was wird jetzt genau bei Hochrisiko-KI-Systemen reguliert?

- Repräsentative Daten: Anbieter von Hochrisiko-KI-Systemen müssen sicherstellen, dass ihre Systeme repräsentative Trainingsdaten verwenden und dass diese für den Nutzungskontext statistisch geeignet sind. Als typische Fehler in diesem Bereich können z.B. KI-Systeme gelten, welche Geräte eher als Waffen erkennen, wenn das Gerät von einer Hand mit dunklem Hautton gehalten wird.

- Transparent und erklärbar: Hochrisiko-KI-Systeme müssen transparent und erklärbar entwickelt und angewandt werden. Die Hochschule müsste bei Bedarf zum Beispiel Auskunft geben können, wie ein durch KI-gestützter Zulassungsentscheid zustande gekommen ist. Dafür muss der Anbieter des KI-Systems klar vermittelt haben, wo das System seine Grenzen hat oder unter welchen Umständen das System nicht eingesetzt werden kann bzw. soll. Philippe Hovaguimian betonte dabei: «Es muss für den Nutzer erkennbar sein, warum ein KI-generiertes Resultat tatsächlich wahr sein könnte – oder eben auch falsch.»

- Robust und sicher: Hochrisiko-KI-Systeme müssen genau und robust sein. Cybersicherheit muss gewährleistet sein und es ist wichtig, dass es eine menschliche Aufsicht gibt. Ein Mensch soll überwachen können, was in der KI passiert, damit er den Output richtig interpretieren kann – und wenn nötig, eingreifen kann.

- Folgenabschätzung durch den Anwender: Selbst die blossen Nutzer von Hochrisiko-KI-Systemen müssen gewisse Verpflichtungen erfüllen, wie namentlich eine Folgenabschätzung bezüglich der Risiken für die Grundrechte der betroffenen Personen – samt allen vorgesehenen Risikominderungsmassnahmen.

Wir bleiben gespannt!

Und last but not least: Wie wird KI im EU AI Act überhaupt definiert?

Ein KI-System wird im EU AI Act als „maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichem Grad an Autonomie operieren kann und das für explizite oder implizite Ziele Ergebnisse wie Vorhersagen, Empfehlungen oder Entscheidungen hervorbringen kann, die das physische oder virtuelle Umfeld beeinflussen“ definiert.

Eine automatisierte Temperaturregulierung für den Kühlschrank könnte also theoretisch auch unter diese breite Definition von KI fallen, wie Philippe Hovaguimian betont. Entscheidend dürfte der Begriff des „unterschiedliche[n] Grad[s] an Autonomie“ sein. Klare Grenzen zwischen KI und blossen statistischen Berechnungen, die ebenfalls für Prognosen verwendet werden, dürften aber in der Praxis schwierig zu ziehen sein. Jedenfalls stehe diese breite Definition von KI einer relativ engen Definition der Hochrisiko-KI-Systemen gegenüber, welche der EU AI Act am meisten betrifft. Eine andere Frage dürfte sein, wie KI-Systeme, welche auf Wahrscheinlichkeit basieren und selbstlernend sind in jedem Fall nachvollziehbar und erklärbar gemacht werden können.

Weiterführendes Material

- Link zum europäischen Parlament und KI-Gesetz und der Gesetzeslink (Originalentwurf von 2021), die letzten Änderungen vom 14. Juni 2023 und eine inoffizielle konsolidierte Fassung (welche die Änderungen vom 14. Juni 2023 integriert).

- KI-campus, Deutschland: Kostenlose Weiterbildungsangebote zu KI und Bildungsangeboten: z.B. Christian Spannagel & Aljoscha Burchardt „Sprachassistenzen als Chance für die Hochschullehre„

- HSLU I „Merkblatt Wissenschaftlichkeit“ ergänzt mit Kapitel 8: Umgang mit ChatGPT und Kapitel 12: Ansprechpartner

Präsentationsfolien EU AI ACT & Hochschulen: Philippe Hovaguimian

Präsentationsfolien Sarah Hauser

Aufnahme: EU AI ACT mit Philippe Hovaguimian und Sarah Hauser