Chatbots halluzinieren oft. Erfahren Sie, wie RAG (Retrieval-Augmented Generation) dieses Problem löst und Chatbots für Unternehmen relevant werden.

Problem: KI halluziniert

Nicht nur Menschen können halluzinieren, sondern auch Maschinen. Bei der KI treten diese Fehlinterpretationen aufgrund von Überanpassungen, Verzerrung oder Ungenauigkeit der Trainingsdaten und einer hohen Modellkomplexität auf. Wenn die KI keine angemessene Antwort liefert, kann das nicht nur mühsam sein, sondern auch zu Problemen und unerwünschten Folgen führen. (IBM, 2023)

Schwerwiegendere Probleme sind die Verbreitung von Fehlinformationen, die zu falschen Entscheidungen für Personen und Unternehmen führen können. Dies kann finanzielle Verluste oder sogar rechtliche Konsequenzen mit sich ziehen.

Was ist RAG und wie funktioniert es?

Retrieval-Augmented Generation (RAG) ist ein KI-Ansatz. Er kombiniert grosse Sprachmodelle (LLMs) mit externem Wissen. So liefert RAG präzisere, aktuellere und mehr auf den Kontext bezogenere Antworten. Herkömmliche LLMs verlassen sich nur auf ihr Training und neigen dazu, Informationen zu halluzinieren oder veraltetes Wissen zu nutzen. RAG agiert hier wie ein dynamisches Gedächtnis. Es ermöglicht Chatbots, in Echtzeit auf zusätzliche Informationen zuzugreifen, diese zu verarbeiten und darauf basierend fundierte Antworten zu generieren. (Meyer, 2025)

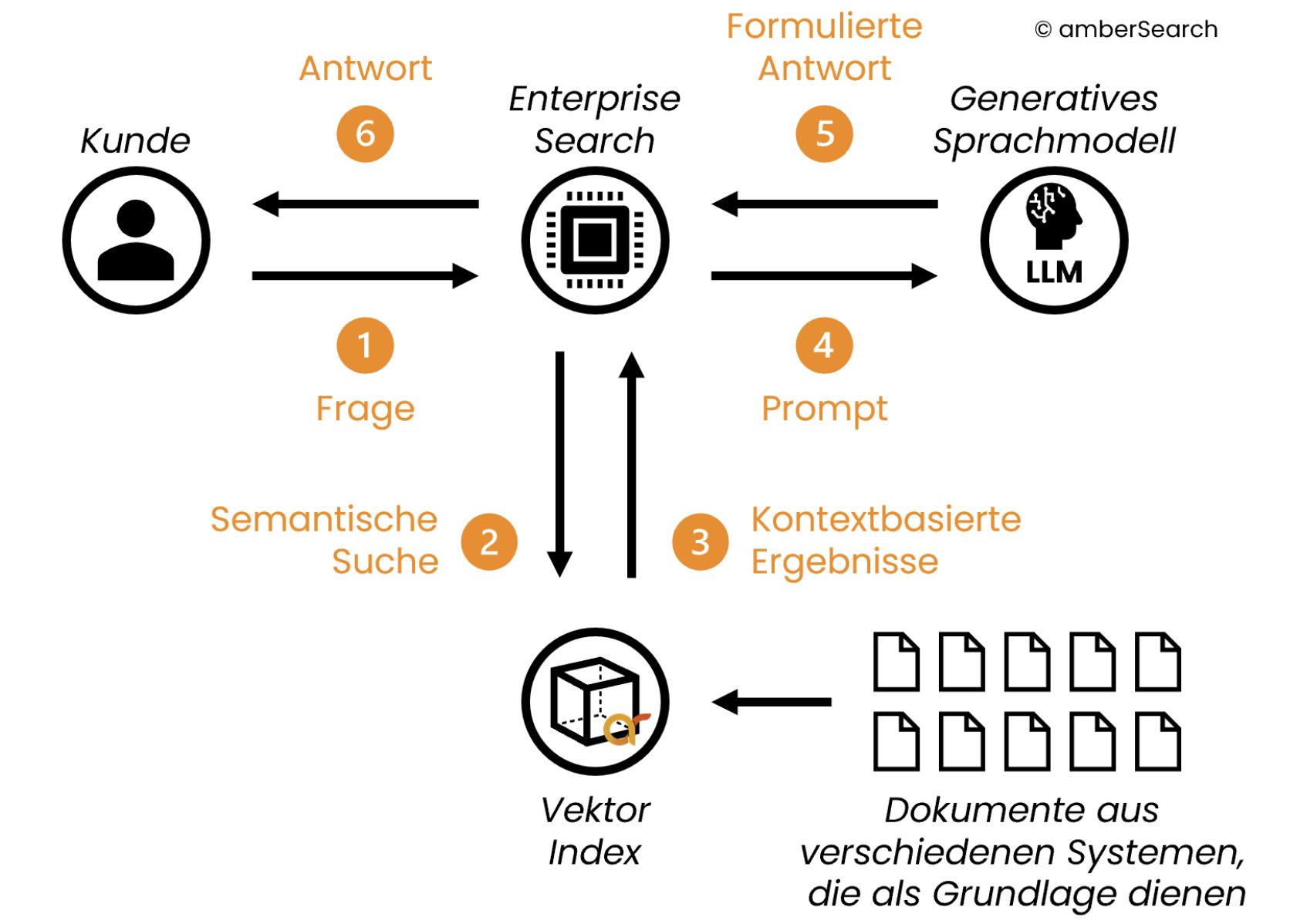

Der Prozess von RAG läuft typischerweise wie folgt ab. Vor der Anfrage der Nutzenden werden die externen Daten bereinigt und in kleine Textstücke (Chunks) aufgeteilt vektorisiert. Nach der Anfrage durchsucht ein spezielles Suchsystem diese Chunks nach relevanten Informationen. Dabei kommen oft sowohl die semantische Suche (die Bedeutung der Wörter) als auch die Keyword-Suche (die exakten Begriffe) zum Einsatz. Die besten Treffer werden dann weiter aufbereitet, beispielsweise zusammengefasst oder umformatiert. In einem nächsten Schritt werden diese aufbereiteten Informationen zusammen mit der ursprünglichen Benutzeranfrage in das LLM eingespeist, das daraufhin eine präzise, faktenbasierte und kontextualisierte Antwort generiert, ohne neu trainiert werden zu müssen. Damit überwindet RAG die Grenzen statischer Wissensbasen und macht KI-Assistenten zuverlässiger und vertrauenswürdiger. (Meyer, 2025)

Wo kann RAG eingesetzt werden?

Retrieval-Augmented Generation (RAG) eröffnet zahlreiche praktische Anwendungsfelder:

- Im Kundenservice: Die RAG-Chatbots können die Kundenanfragen präziser beantworten. Sie greifen auf aktuelle Produktdaten, FAQs oder individuelle Kundenhistorien zu, was zu persönlicheren Antworten führt und die Kundenzufriedenheit erheblich steigert.

- Im internen Wissensmanagement: In Unternehmen ist RAG ebenfalls ein Game-Changer. Mitarbeiter finden schneller faktenbasierte Antworten zu Unternehmensrichtlinien, HR-Prozessen oder technischen Dokumentationen. RAG durchsucht interne Dokumente und liefert relevante Informationen, was die Effizienz erhöht, und die Einarbeitung neuer Kollegen erleichtert.

- Bei der Dokumentenzusammenfassung: Das System kann lange Texte effizient zusammenfassen und extrahiert die wichtigsten Informationen aus komplexen Dokumenten. Dies spart Nutzern wertvolle Zeit beim Lesen und Verstehen.

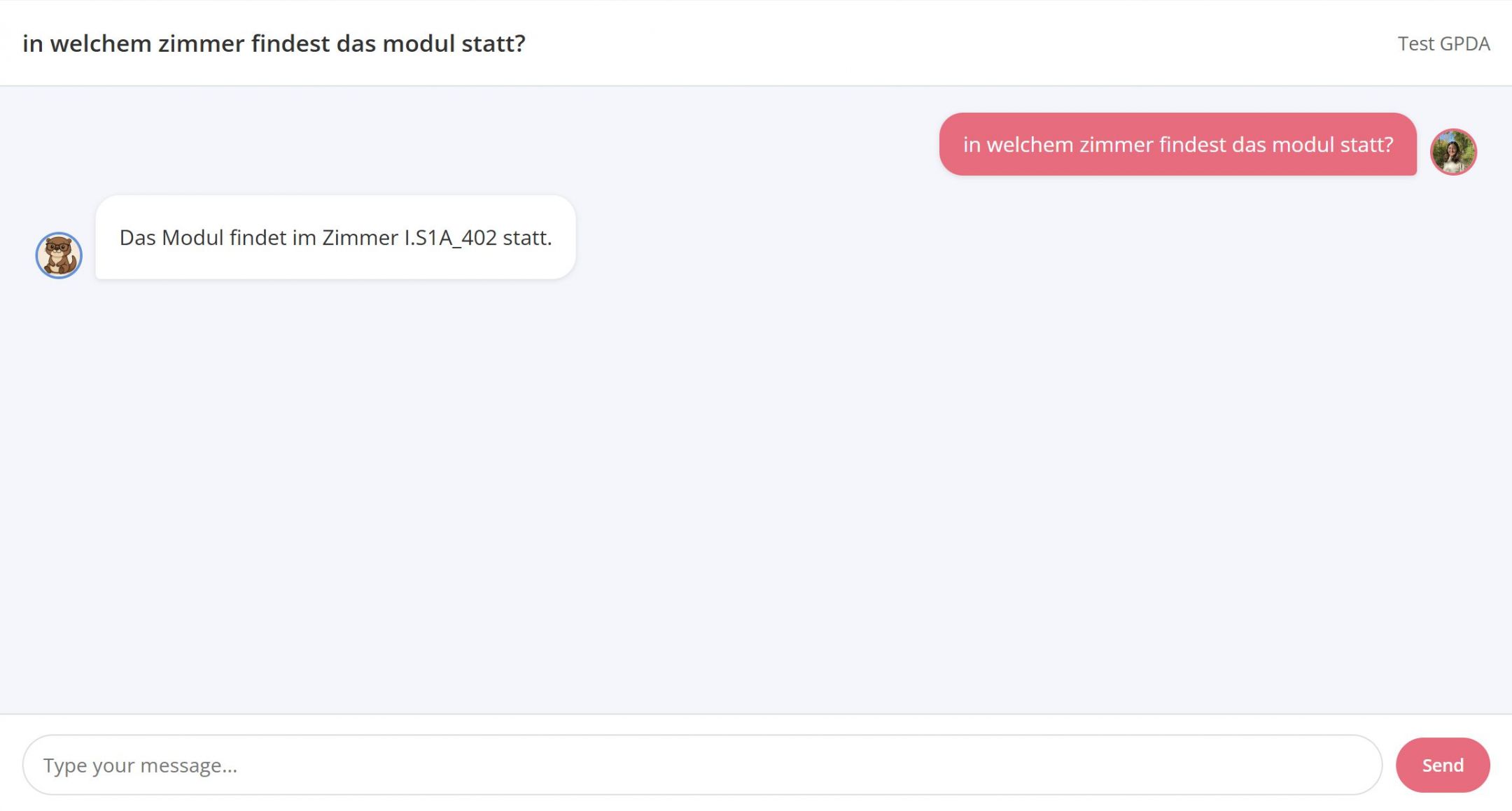

- Beim Lernen: RAG unterstützt und personalisiert das Lernen, indem es auf eine Vielzahl von Lehrmaterialien zugreift. Studenten erhalten präzise Erklärungen und zusätzliche Ressourcen, was ein tieferes Verständnis und individuelles Lernen fördern.

Was sind die Vorteile?

Die Integration von RAG-Systemen bringt entscheidende Vorteile mit sich, die die Leistungsfähigkeit und Vertrauenswürdigkeit von KI-Assistenten massgeblich verbessern:

- Weniger Halluzinationen: RAG reduziert falsche oder erfundene Informationen. Durch den Zugriff auf Quellen werden Antworten faktenbasiert.

- Genauere Antworten: Da RAG-Systeme Informationen und Daten abrufen, sind die Ergebnisse präziser und besser auf den Kontext zugeschnitten.

- Aktualität der Daten: RAG-Systeme bleiben aktuell, indem es Zugriff auf Daten aus Live-Feeds, Datenbanken oder APIs ermöglicht, wodurch die Antworten stets auf dem neusten Stand sind.

- Datensicherheit: Ein Sicherheitsvorteil ist, dass sensible Unternehmensdaten nicht direkt im LLM integriert werden müssen. Die Daten bleiben extern gespeichert und werden nur für den Kontext abgerufen, was das Risiko von Datenlecks minimiert.

Fazit

Die Tendenz von KI zu Halluzinationen war lange eine grosse Herausforderung. Doch RAG bietet hier eine elegante Lösung. Es stattet LLMs mit einem dynamischen Gedächtnis aus, das externe, aktuelle Informationen integriert. Dies führt zu präziseren und zuverlässigeren Antworten in Bereichen wie Kundenservice und Wissensmanagement. Für mich ist klar: RAG verändert nachhaltig, wie wir auf Informationen zugreifen und sie nutzen, und ebnet den Weg für eine vertrauenswürdigere und intelligentere digitale Zukunft.

Weiterführende Links

- Erstellung eines RAG-Chatbot: https://blog.n8n.io/rag-chatbot/

- RAG-Chatbot technische Dokumentation: https://www.rtr.at/rtr/service/ki-servicestelle/chat/technik.de.html

- Wie es in der Realität aussieht: https://www.reddit.com/r/Rag/comments/1hl9x4i/trying_to_build_a_rag_chat_bot_turned_into_my/

- Vektordatenbank: https://www.elastic.co/de/what-is/vector-database

Quellen

Bilder:

Titelbild: Generiert mit Deepai

Video: https://www.youtube.com/watch?v=6xNqqIqyy38&t=157s

Grafik Ablauf Anfrage: https://www.open-telekom-cloud.com/de/blog/referenzen/ki-chatbot-otc

Beispiel RAG-Chatbot: beUnity.ai

Recherche:

IBM. (2023, September 1). Was sind KI-Halluzinationen? https://www.ibm.com/de-de/think/topics/ai-hallucinations

Meyer, V. (2025, September 3). Retrieval-Augmented Generation (RAG): Der Wissens-Booster für LLMs. Moin.ai. https://www.moin.ai/ch/chatbot-lexikon/retrieval-augmented-generation-rag

Dieser Blog-Beitrag wurde mit Unterstützung des Sprachmodells Gemini erstellt.