Kritische Vorfälle: Wenn Daten in die falschen Hände geraten

ChatGPT geriet bereits mehrfach aufgrund von Datenlecks und Sicherheitsrisiken in die Schlagzeilen. Ein besonders gravierender Vorfall ereignete sich am 20. März 2023. Der Dienst wurde plötzlich für mehrere Stunden offline genommen. Wie der Konzern am 24. März 2023 auf seiner Website bekannt gab, war die Ursache ein schwerwiegender Fehler in einer Open-Source-Bibliothek, der es Nutzern ermöglichte, die Titel von Chatverläufen anderer aktiver Benutzer einzusehen. In einigen Fällen war sogar die erste Nachricht einer neuen Unterhaltung im Verlauf eines anderen Nutzers sichtbar, wenn beide zeitgleich aktiv waren. (OpenAI. (2023))

Dieser Vorfall verdeutlicht die erheblichen Risiken, die mit der Nutzung von ChatGPT verbunden sind. Eine Analyse des Cybersecurity-Anbieters Kaspersky ergab, dass ChatGPT-Nutzer im Jahr 2023 ein häufiges Ziel für Angriffe waren. Im Darknet wurden die Daten von fast 664’000 Chatbot-Nutzern entdeckt, die potenziell in die falschen Hände gelangen konnten. (Netzwoche. (2024, 4. April))

Ein Beispiel dafür, wie leicht vertrauliche Firmendaten durch unachtsames Verhalten von Mitarbeitern an ChatGPT gelangen können, liefern drei dokumentierte Vorfälle bei Samsung. Innerhalb von 20 Tagen nutzten Mitarbeiter den Chatbot, um sensible Informationen zu verarbeiten. In einem Fall übermittelte ein Ingenieur den Code eines streng geheimen Programms, um Fehler zu beheben. In einem anderen Fall wurden Testmuster, die in der Halbleiterbranche zur Chipentwicklung genutzt werden und einen hohen finanziellen Wert besitzen, in das Chat-Feld eingegeben, um Optimierungsvorschläge zu erhalten. (t3n. (n.d.))

Die Kombination aus dokumentierten Sicherheitslücken und der unüberlegten Eingabe vertraulicher Informationen verdeutlicht die Notwendigkeit eines verantwortungsvollen Umgangs mit ChatGPT.

Rechtlicher Rahmen: KI ohne klare Regeln

Die Schweiz hat bislang keine spezifische Regulierung für KI und verschob einen ursprünglich für 2024 erwarteten Vorschlag auf 2025. (Die Bundeskanzlei. (n.d.).) Während Länder wie die USA aktiv KI-Regeln entwickeln, verfolgt die Schweiz einen abwartenden Ansatz.

Um das Vertrauen der Bevölkerung in KI zu stärken, muss eine Regulierung von KI für Transparenz und Nachvollziehbarkeit sorgen – Bundesrat Albert Rösti, (Die Bundeskanzlei. (n.d.).)

Wie ChatGPT Daten verarbeitet

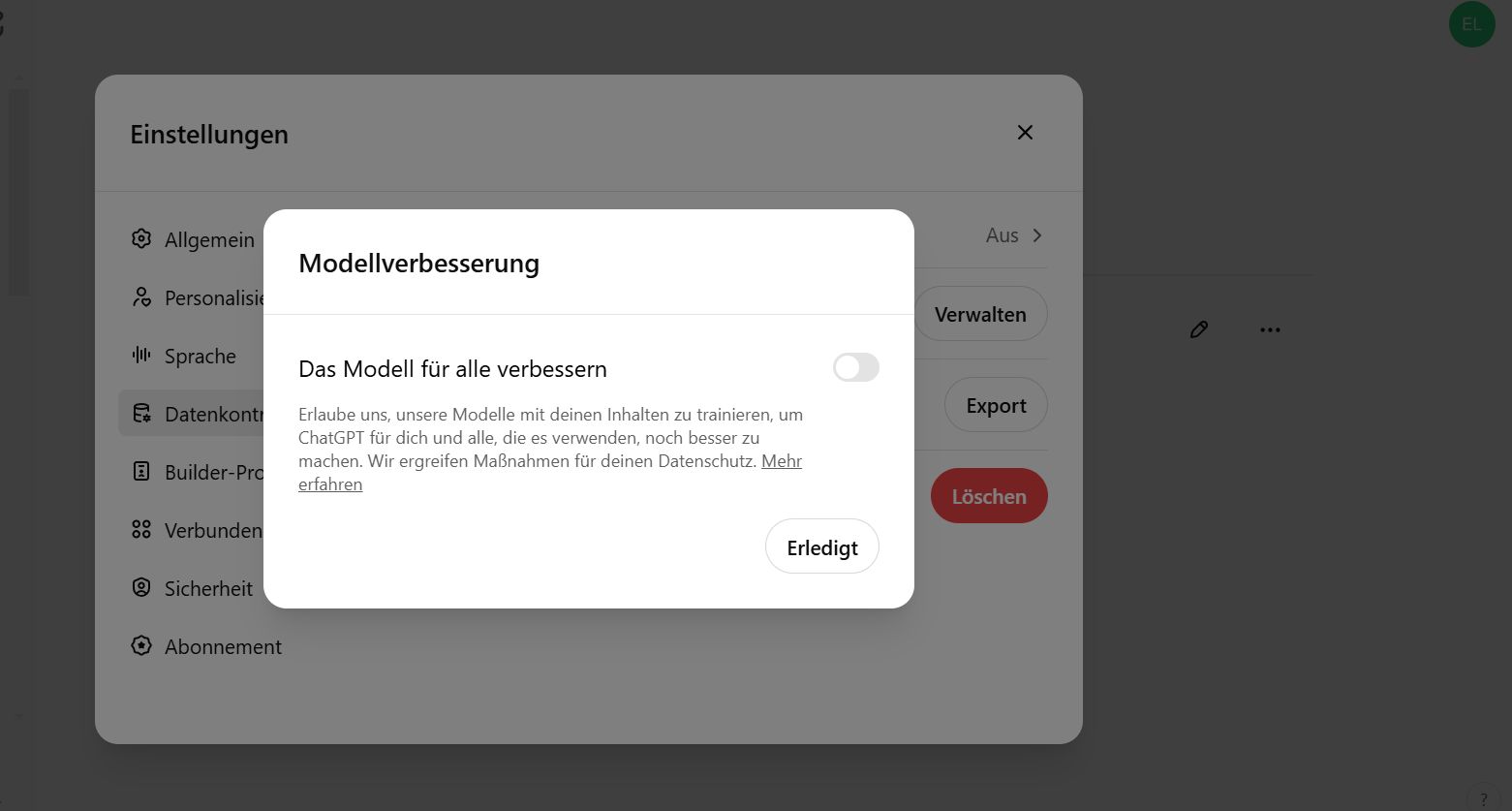

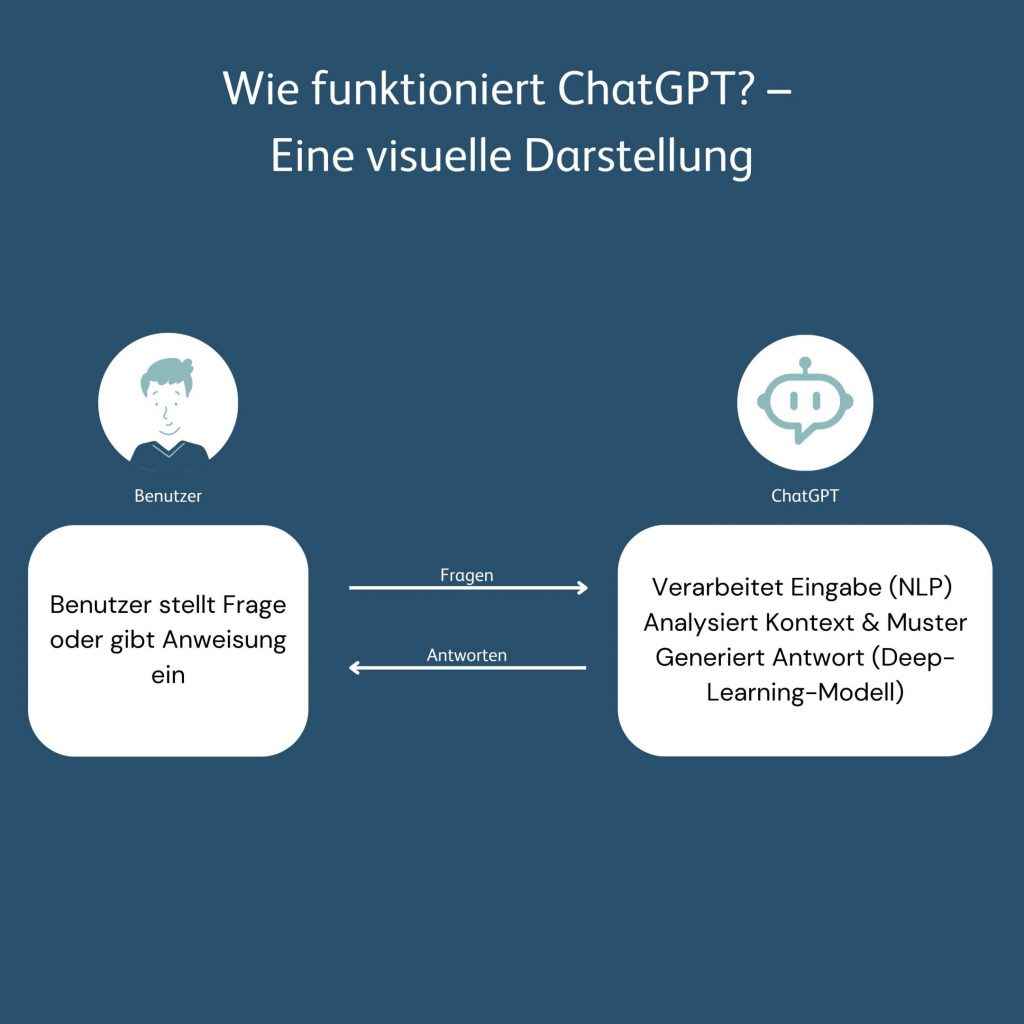

Die Funktionsweise von ChatGPT basiert auf maschinellem Lernen und Deep Learning. Mithilfe natürlicher Sprachverarbeitung (NLP) analysiert das Modell Benutzereingaben, erkennt Schlüsselwörter und Kontext und liefert darauf präzise Antworten. Diese innovative Technologie ermöglicht nahtlose Mensch-KI-Interaktionen – birgt aber auch Risiken. Dabei werden Benutzereingaben häufig genutzt, um das Modell weiter zu trainieren und zu verbessern.

Fazit: Verantwortungsbewusster Umgang ist Pflicht

ChatGPT bietet enormes Potenzial, stellt jedoch auch erhebliche Herausforderungen dar. Mit der richtigen Strategie können Unternehmen die Vorteile der KI nutzen, ohne die Sicherheit ihrer Daten zu gefährden.

Teile dieses Blog-Beitrags wurden mit Hilfe von ChatGPT erstellt.

Quellen:

Titelbild von pixabay am 11.01.2025 heruntergeladen: https://pixabay.com/photos/chat-ai-chatbot-chatgpt-mobile-7767693/

Schmidtis Blog. (n.d.). ChatGPT wächst rasant: 300 Millionen aktive Nutzer pro Woche. Abgerufen am 11. Januar 2025, von https://www.schmidtisblog.de/chatgpt-waechst-rasant-300-millionen-aktive-nutzer-pro-woche-1764134/

Wildhaber, I. (2023). Künstliche Intelligenz im Unternehmen: Chancen, Risiken und rechtliche Herausforderungen. Universität St. Gallen. Abgerufen am 11. Januar 2025, von https://faa.unisg.ch/fileadmin/user_upload/HSG_ROOT/Institut_FAA/09_Presse/Wildhaber/2023_3_17_leader_maerz_23_low_neu.pdf

OpenAI. (2023). March 20 ChatGPT Outage. Abgerufen am 11. Januar 2025, von https://openai.com/index/march-20-chatgpt-outage/

t3n. (n.d.). Samsung Semiconductor: Datenleck bei ChatGPT – Geschäftsgeheimnisse gefährdet. Abgerufen am 11. Januar 2025, von https://t3n.de/news/samsung-semiconductor-daten-chatgpt-datenleck-1545913/

Netzwoche. (2024, 4. April). Millionen Kontodaten von ChatGPT- und Canva-Usern landen im Darknet. Abgerufen am 11. Januar 2025, von https://www.netzwoche.ch/news/2024-04-04/millionen-kontodaten-von-chatgpt-und-canva-usern-landen-im-darknet

Universität St. Gallen. (n.d.). ChatGPT aus rechtlicher Perspektive: Was Unternehmen beachten sollten. Abgerufen am 11. Januar 2025, von https://www.unisg.ch/de/videodetail/news/chatgpt-aus-rechtlicher-perspektive-was-unternehmen-beachten-sollten

Die Bundeskanzlei. (n.d.). Reden der Bundesräte. Abgerufen am 11. Januar 2025, von https://www.admin.ch/gov/de/start/dokumentation/reden/reden-der-bundesraete.msg-id-103199.html